Tóm tắt nội dung

Bạn đã bao giờ thắc mắc làm cách nào mà bộ máy tìm kiếm của Google có thể phân phân tích dữ liệu của một website chưa? Đó chính là nhờ file Robots.txt.

Vậy cụ thể File Robots.txt là gì? Cách hoạt động của file này như nào?… Trong bài viết dưới đây, SEO Thành Công sẽ cung cấp cho bạn những thông tin hữu ích về tệp Robots.txt, cùng tìm hiểu nhé!

Khái niệm của tập tin Robots.txt

1. File Robots.txt là gì?

Robots.txt được biết đến là một phần của Robots Exclusion Protocol (REP) chứa một nhóm các tiêu chuẩn trang web. Robots.txt là một tệp chứa các tập tin dưới dạng .txt.

Nó giúp thu thập dữ liệu của các công cụ tìm kiếm nhận biết được trang hoặc tệp nào trình dữ liệu có thể hoặc không thể yêu cầu thu thập dữ liệu trong website của bạn.

Nhờ Robots.txt, bạn có thể ngăn cản việc trình thu thập dữ liệu gửi quá nhiều yêu cầu về cho trang web của bạn.

2. File Robots.txt dùng cho mục đích gì?

Tùy thuộc vào từng loại tệp, Robots.txt sẽ hỗ trợ bạn quản lý lưu lượng truy cập của trình thu thập dữ liệu vào website của bạn hoặc thường được dùng để ẩn một trang nào đó khỏi Google. Cụ thể:

- Quản lý lưu lượng truy cập: Trang web, tệp đa phương tiện và tệp tài nguyên.

- Ẩn khỏi Google: Tệp đa phương tiện, tệp tài nguyên.

Tập tin robots.txt là gì? Robot.txt có tác dụng gì?

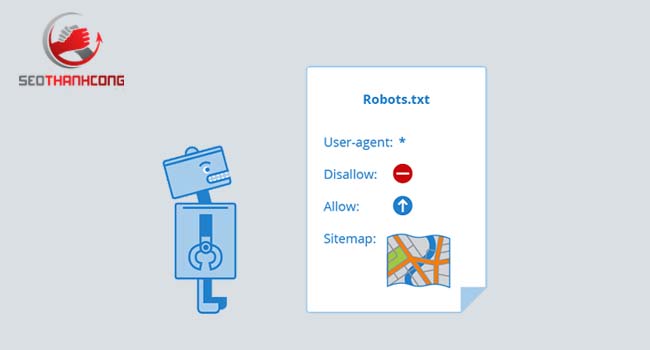

3. Cách thức hoạt động file Robots.txt là gì?

Robots.txt là tệp có cấu trúc rất đơn giản, được kết hợp một số từ khóa/ giá trị đã xác định trước mà chúng ta có thể sử dụng. Trong đấy, được biết đến phổ biến nhất là: User-agent, Disallow, Allow, Crawl-delay, Sitemap.

- User-agent: Sẽ chỉ định trình thu thập dữ liệu nào sẽ được đưa vào các chỉ thị. Có thể dùng một * cho tất cả các trình thu thập thông tin, hoặc chỉ định tên cho trình thu thập thông tin.

- Disallow: Hướng dẫn các bot (đã được chỉ định) không thu thập dữ liệu URL hay một phần của website. Disallow có giá trị có thể là một tệp, URL hoặc một thư mục cụ thể.

- Allow: Chỉ thị cho biết rõ những trang hoặc một thư mục con nào có thể được truy cập (Chỉ áp dụng cho Googlebot). Bạn có thể dùng Allow để cho phép truy cập vào một thư mục con cụ thể nào đó trên trang web của mình, cho dù thư mục gốc là không được phép.

- Crawl-delay: Xác định thời gian (được tính bằng giây) các bot phải chờ đợi trước khi được chuyển sang phần tiếp theo. Điều này sẽ rất có ích trong trong việc ngăn chặn các Search Engine Load Server một cách tùy tiện.

- Sitemap: Chỉ thị được hỗ trợ nhờ vào các công cụ tìm kiếm chính bao gồm Google, được dùng để chỉ định vị trí của sơ đồ trang web XML của bạn. Trong trường hợp bạn không chỉ định vị trí sơ đồ XML cho trang web của mình, các công cụ tìm kiếm vẫn sẽ tìm thấy được nó.

4. Cách tạo File Robots.txt chuẩn SEO

Vậy là bạn đã biết được File robots.txt là gì? Tiếp theo, hãy cùng chúng tôi tìm hiểu cách tạo Robots.txt chuẩn SEO bạn nhé. Đầu tiền, việc bạn cần làm đó chính là một trình soạn thảo văn bản và truy cập vào các tệp trên website của bạn thông qua FTP hay bảng điều khiển quản lý hosting.

Để tạo file Robots.txt rất đơn giản, tạo theo cú pháp sau đây nhé: Trong tệp này bạn sẽ viết những cú pháp nhất định để thể hiện mục đích của bạn.

- User-agent: tên bot mà bạn muốn áp dụng

- Disallow: không cho phép Bot (abcxyx) trong mục User-Agent truy cập vào website

- Allow: cho phép Bot được truy cập & thu thập dữ liệu

- Dấu *: áp dụng cho tất cả mọi trường hợp

Ví dụ như:

- User-agent: * (Áp dụng với tất các các loại bot)

- Disallow robots.txt: / (Chặn Bot không được phép truy cập vào website

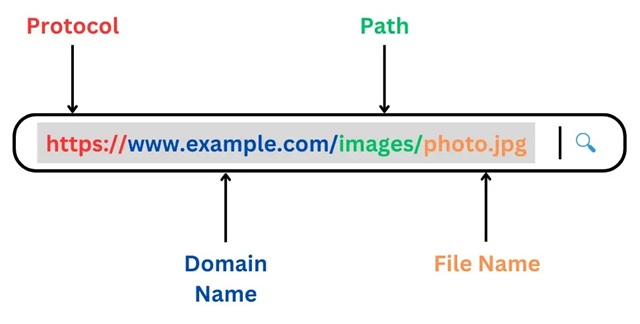

Lưu ý, trước khi tiến hành tạo một tệp tin Robots.txt, bạn cần kiểm tra lại một lần nữa xem nó đã tồn tại hay chưa. Để kiểm tra, bạn có thể truy cập theo cú pháp như sau: https:www.tenmien.com/robots.txt

File robots.txt là gì? Cách chặn file Robot.txt & công dụng trong SEO?

5. Cách chặn file Robot.txt trong SEO – đối thủ không check được site

Nhiều anh em làm SEO mà mảng cạnh tranh hoặc hay bị đối thủ chơi xấu phá site, bắn link bẩn…thì hôm nay mình hướng dẫn anh em 1 cơ chế chặn file Robot.txt – cách này sẽ khiến đối thủ không check ra site mình.

Hoặc nhiều anh em đang build hệ thống link khoảng 100 website đi, nhiều anh em không muốn đối thủ dò ra hệ thống thì cũng có thể dùng cách này.

Cách chặn như sau: Bạn Disallow các công cụ check link phổ biến như Ahrefs, Majestic… hoặc bất kỳ công cụ nào mà check được link của website.

Lưu ý: Tuy nhiên, nếu bạn chặn Bot Ahrefs chẳng hạn, bạn cần chặn 2 đầu. Tức Web A bạn chặn Bot thì Web B cũng phải chặn Bot Ahrefs.. Nếu bạn chỉ chặn 1 trong 2 web chẳng hạn thì đối thủ họ dò ra từ web còn lại thì cũng không có tác dụng đâu nhé.

SEO Thành Công đã chia sẻ những thông tin hữu ích giúp bạn hiểu được file Robots.txt là gì cũng như tại sao cần tạo File Robots.txt cho website của bạn. Ngay bây giờ hãy kiểm tra xem website của mình đã có Robots.txt chưa, và nếu chưa hãy tạo ngay cho trang web của mình một File Robots.txt để hỗ trợ bots của các công cụ tìm kiếm thu thập dữ liệu website của bạn một cách hiệu quả.

Nguồn: SEO Thành Công