Tóm tắt nội dung

Thuật ngữ Crawling là một khái niệm cơ bản mà mọi SEOer đều nắm được. Nhưng nếu là một SEOer mới, bạn có thể tham khảo những thông tin cơ bản về Crawl data là gì, các yếu tố ảnh hưởng đến quá trình Crawl website trong bài viết dưới đây.

Tổng quan về Crawl Data

1. Crawl data là gì?

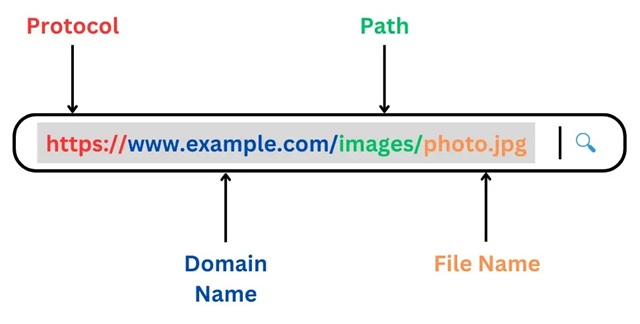

Crawler nghĩa là gì hay Web Crawler là gì – Thuật ngữ này mô tả quá trình thu thập thông tin. Các công cụ tìm kiếm sẽ đưa ra một nhóm Googlebot (trình thu thập dữ liệu) để tìm các nội dung mới và cập nhật.

Cơ chế của Crawl là thu thập dữ liệu của 1 trang bất kỳ. Đầu tiên, Googlebot sẽ tìm nạp một số website và đi theo các liên kết ở những trang web này để tìm ra các URL mới. Theo cách hoạt động này, trình thu thập dữ liệu có thể phát hiện các nội dung mới và nhập vào bộ nhớ. Sau đó tiến hành phân tích cho vào bộ nhớ dữ liệu và trả ra tiêu chí theo truy vấn của người dùng.

2. Các yếu tố ảnh hưởng đến quá trình Crawl dữ liệu là gì?

2.1. Cấu trúc thông tin của trang web không rõ ràng

Một điều cần lưu ý là cấu trúc thông tin website của bạn. Nếu cấu trúc trang web không logic hoặc không phải là những gì mà họ mong muốn tìm kiếm thì họ chắc chắn sẽ rời khỏi website của bạn.

Hơn nữa, nội dung của website không hữu ích cho người dùng như: nội dung copy, nội dung quá dài, hay quá ngắn, nội dung mỏng…sẽ không mang lại giá trị cho họ. Họ cũng sẽ rời khỏi trang ngay lập tức.

2.2. Thiếu file Sitemap.xml

Sitemap hay sơ đồ trang web là danh sách các URL tại trang web của bạn mà Googlebot sử dụng để khám phá và thiết lập chỉ mục nội dung.

Cách đơn giản nhất để trình thu thập dữ liệu phát hiện các trang web của bạn là tạo một file Sitemap.xml. Các tệp này hỗ trợ đáp ứng các tiêu chuẩn của Google. Từ đó, quá trình thu thập thông tin sẽ hướng theo một đường dẫn tới tất cả các trang web quan trọng.

Crawl website là gì? Tìm hiểu về Web Crawler – Cách tối ưu quá trình Crawling

3. Cách tối ưu Bot công cụ tìm kiếm Crawl data là gì?

3.1. Sử dụng Robots.txt

Robots.txt là các tệp tin được lưu trữ trong thư mục gốc của trang web. Với các chỉ thị cụ thể, tập này sẽ đưa ra đề xuất cho công cụ tìm kiếm phần nào trên web của bạn nên thu thập thông tin và tốc độ thu thập.

Mục đích của việc sử dụng Robots.txt là hướng Googlebot ra khỏi web hay các phần nhất định trên web.

- Trường hợp Googlebot không tìm được Robots.txt ở trang web:nó sẽ thực hiện thu thập dữ liệu của trang đó

- Trường hợp Googlebot có thấy Robots.txt: nó sẽ tuân theo đề xuất của tệp

- Trường hợp Google gặp lỗi: khi đang cố gắng truy vấn các tệp Robots.txt của trang, nó sẽ không tiến hành thu thập dữ liệu.

Sử dụng robots.txt giúp tối ưu Crawler

3.2. Tối ưu hóa ngân sách thu nhập

Ví dụ: Bot Google thường thu thập dữ liệu website của tôi khoảng 3000 lần/ tháng đi. Có thể coi rằng, 3000 là ngân sách thu thập dữ liệu hàng tháng của website tôi cho Google. (Tuy nhiên đây chỉ là giả thiết mà tôi đặt ra, ngân sách sẽ tùy thuộc vào từng website).

Nói một cách logic là việc ngân sách thu thập dữ liệu khá quan trọng. Bởi, ngân sách thu thập dữ liệu càng lớn thì việc Google nhanh chóng tìm thấy nội dung mới trên website của bạn sẽ càng nhanh.

Một số cách áp dụng giúp tối ưu hóa ngân sách thu thập dữ liệu:

- Sử dụng RSS

- Chăm sóc cấu trúc web và liên kết nội bộ

- Tìm và sửa lỗi HTTP status

- Tránh các trang chuyển hướng dài như 301, 302.

- Sơ đồ trang web (sitemap) phải được cập nhật thường xuyên và không có các trang lỗi

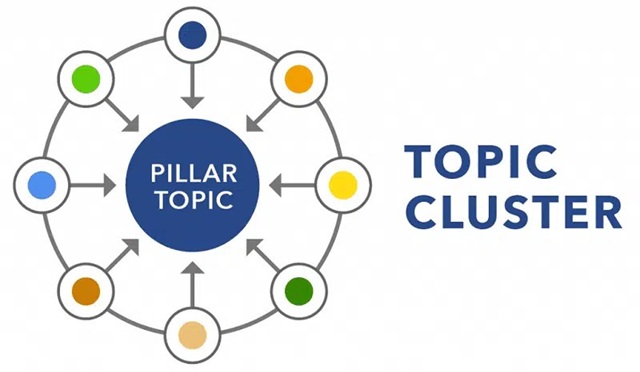

3.3. Tối ưu rõ cấu trúc website

Thật ra, một website mới sử dụng cấu trúc silo là tốt nhất. Cấu trúc silo giúp phân cấp nội dung trên website theo chủ đề. Nếu bạn sử dụng cấu trúc website chuẩn SEO – cấu trúc silo hiệu quả thì không những giúp con Bot Google thu thập dữ liệu dễ dàng, đơn giản mà còn có lợi cho chiến lược SEO lâu dài của bạn.

3.4. Tối ưu nội dung

Có thể nhiều bạn không biết, nội dung copy sẽ bị hạn chế trong việc Google thu thập dữ liệu. Bởi con Bot của Google sẽ quét các liên kết từ các trang hiện có đến các trang mới, chúng sẽ thu thập lại dữ liệu cũ xem có điều gì thay đổi không.

Các nội dung trùng lặp sẽ tạo thêm thời gian Google xử lý thông tin. Điều đó sẽ ảnh hưởng đến tốc độ và tần suất mà Bot Google thu thập dữ liệu như mình đã nói ở phần (3.2.) trên các trang mới hoặc các cập nhật mới trên website bạn.

Vì vậy, thay vì đi cóp nhặt nội dung, hãy sáng tạo nội dung và làm mới chúng thường xuyên.

Cách để ngăn chặn Crawling hiệu quả

4. Cách để ngăn Google Crawling dữ liệu không quan trọng trên Website

Vậy là bạn đã biết được Crawl data là gì? Tiếp theo, hãy cùng STC tìm hiểu cách để ngăn chặn việc Crawling dữ liệu không quan trọng trên website.

Việc đảm bảo cho Google luôn thấy được trang web của bạn là điều quan trong SEO. Nhưng đôi khi, bạn lại không muốn bị Google tìm những website:

- Có URL cũ, nội dung mỏng

- CÓ URL trùng lặp

- Có mã quảng cáo đặc biệt

- Website dàn dựng hoặc thử nghiệm.

Để ngăn Google Crawl những dữ liệu không quan trọng trên Website, bạn có thể tham khảo những phương pháp dưới đây:

4.1. Điều hướng Robot.txt

Các tệp Robots.txt được đặt trong thư mục gốc của website. Và trong tệp Robot này có lệnh Disallow – tức là không cho phép Bot truy cập vào tệp này. Trong trường hợp bạn không muốn Bot Crawl dữ liệu ở những trang web không quan trọng thì hãy để chúng ở lệnh Disallow.

Tham khảo thêm: Cách thức hoạt động của file Robot.txt

4.2. Đặt thẻ “Noindex”

Cách để ngăn Bot crawl lập chỉ mục những trang không cần thiết bạn sử dụng lệnh “noindex” vào mã HTML của website đó. Thực tế thì Google vẫn quét trang này, nhưng Google sẽ không xếp hạng, đánh giá bất cứ thứ gì của trang đặt thẻ Noindex.

Việc tối ưu quá trình Crawling website là việc rất quan trọng trong quá trình tối ưu hóa website. Với những thông tin hữu ích về Crawl data là gì, cách tối ưu Bot Crawl website như thế nào mà SEO Thành Công đã chia sẻ trong bài viết trên. Hy vọng, các bạn sẽ có chiến lược sử dụng hiệu quả các bot công cụ tìm kiếm.

Nguồn: SEO Thành Công